IEEE trans :一种高效的**视角脊髓损伤患者手部康复视频检测方法

2021-06-08 MedSci原创 MedSci原创

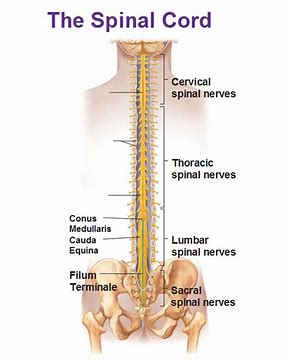

颈脊髓损伤(SCI)显著降低了受影响个体的生活质量,尤其是手臂和手部功能的损害在脊髓损伤后的独立运动功能丧失中起主要作用。颈椎SCI患者认为恢复上肢功能是他们期望的首要康复任务。需要新的治疗方法来改善

颈脊髓损伤(SCI)显著降低了受影响个体的生活质量,尤其是手臂和手部功能的损害在脊髓损伤后的独立运动功能丧失中起主要作用。颈椎SCI患者认为恢复上肢功能是他们期望的首要康复任务。需要新的治疗方法来改善脊髓损伤后的手功能。目前对上肢损伤严重程度的评估通常在临床环境中进行。为准确反映新干预措施对患者功能的真正影响,应在家中进行评估。目前,在家中还没有直接测量和跟踪治疗对患者手功能影响的方法。

随着谷歌眼镜(googleglass)和GoPro等可穿戴相机的出现,SCI患者在家中直接测量手功能的创新方法已经成为可能。事实上,可穿戴相机已经被用于收集数据和评估人类互动 。可穿戴相机很有意义,因为它们从相机佩戴者的角度捕捉活动,可以用来了解日常活动,如做饭和其他功能性的自我护理任务。第一人称摄像头还允许进行大数据采集,与限制在一个位置的固定摄像头相比,限制较少。家庭康复是最有意义的,因为可穿戴相机提供的自然运动信息可用于监测患者在日常生活活动(ADL)中的表现和独立性,并为更有效和更易获得的康复提供反馈。

尽管可穿戴摄像机的视频可用于监视患者在家中的活动,但使用计算机视觉对以自我为中心的视频进行自动分析带来了重大的技术挑战。在以自我为中心的视频中,手的检测是手功能分析的第一步。例如,一旦确定了手的位置,就可以使用额外的处理算法来量化个人在家庭环境中的功能性手的使用(交互检测),从而得出上肢评估的有意义的结果度量,分析手的姿势和抓握类型,并识别活动。因此,本研究的目的是通过在准确度和速度之间找到最佳的平衡点,来产生一种快速可靠的算法,用于在颈椎SCI患者拍摄的以自我为中心的视频中进行手部检测。将目标检测技术与跟踪算法相结合,提出了一种简单而新颖的方法,在以自我为中心的视频中,该方法可以提高手部检测算法的计算效率,并具有很好的准确性。

算法流程

临床评估,如分级重新定义的力量敏感性和抓握评估(GRASSP)和脊髓独立性测量(SCIM),通常在医院中评估,并不能直接捕捉干预措施对一个人在家中日常生活的真实影响 。因以前使用的物理传感器系统包括测角仪、加速计、压电压力传感器、柔性传感器和惯性传感器。监测上肢功能最常见的方法是使用腕带加速计。然而,这种方法更适合检测手臂的运动,可能无法捕捉与灵巧手使用相关的更精细的运动。用于手部的可穿戴传感器系统的开发远远不够。特别是对于手部功能,已经提出了机械手套系统、磁环和手指佩戴的加速计,但还需要进一步研究,以确定这些系统在无约束环境和任务中的可行性。在这种情况下,以自我为中心的视频很有吸引力,因为它不仅可以捕捉手本身的信息,还可以捕捉手与环境的互动信息。

不同算法结果

分析以自我为中心的视频中手的功能,首先检测手是很重要的。在进一步分析(如手部分割)之前,手部检测步骤非常重要。手部检测是计算机视觉中一个较为普遍和基本的问题的具体应用,称为目标检测。近年来,卷积神经网络在提高目标检测性能方面取得了重大进展 。为了提高速度,引入了更快的R-CNN,它既提高了速度又提高了精度,但仍远低于实时(这里定义为每秒30帧(FPS))。You Only Look Once(YOLO)是一种算法,它使用一个CNN同时预测边界框和类概率,第二个版本的YOLO(YOLOv2)在准确度和速度上都优于更快的R-CNN,同时实时执行。另一种基于回归的算法优于更快的R-CNN,是SSD 检测算法 。SSD框架在设计上类似于YOLOv2,但是它包括以卷积方式使用不同纵横比的特征图来可视化图像。用于本研究的以自我为中心的手部检测数据集是从先前的实验中获得的,这些实验导致使用可穿戴相机采集SCI患者的视频,称为自适应神经康复系统(ANS)SCI数据集 。设计了检测和跟踪算法。手部检测的最终性能通过测试集上的F1分数来评估。

所有检测算法的F1评分都很接近,主要的区别在于系统的速度。所有的在线跟踪算法对遮挡或快速运动都不具有鲁棒性,因此在手部跟踪中受到影响。在线跟踪器高度依赖于用户初始化和视频质量,导致F1分数的标准差较大。在线跟踪算法本身也不足以用于以自我为中心的视频中的手部检测,因为它们无法从遮挡和快速运动中恢复。将相对快速的检测算法与相对精确的跟踪器相结合,可以最大限度地减少每种方法的缺陷,从而实现准确有效的手部检测。与单独使用跟踪器相比,这些组合显示出更低的标准差,这表明增加了检测模块,使得系统更加健壮和可靠。本系统将有助于评估新疗法对SCI患者生活的真正影响,以及涉及手功能的其他康复应用。

R. J. Visée, J. Likitlersuang and J. Zariffa, "An Effective and Efficient Method for Detecting Hands in Egocentric Videos for Rehabilitation Applications," in IEEE Transactions on Neural Systems and Rehabilitation Engineering, vol. 28, no. 3, pp. 748-755, March 2020, doi: 10.1109/TNSRE.2020.2968912.

本网站所有内容来源注明为“梅斯医学”或“MedSci原创”的文字、图片和音视频资料,版权均属于梅斯医学所有。非经授权,任何媒体、网站或个人不得转载,授权转载时须注明来源为“梅斯医学”。其它来源的文章系转载文章,或“梅斯号”自媒体发布的文章,仅系出于传递更多信息之目的,本站仅负责审核内容合规,其内容不代表本站立场,本站不负责内容的准确性和版权。如果存在侵权、或不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。

在此留言

#TRA#

64

#复视#

76

#损伤#

65

#检测方法#

88